Ce texte a été co-écrit avec Claude IA (Révision version 1 du texte, analyse OCR du modèle PRAX-IA et révision de la version 2)

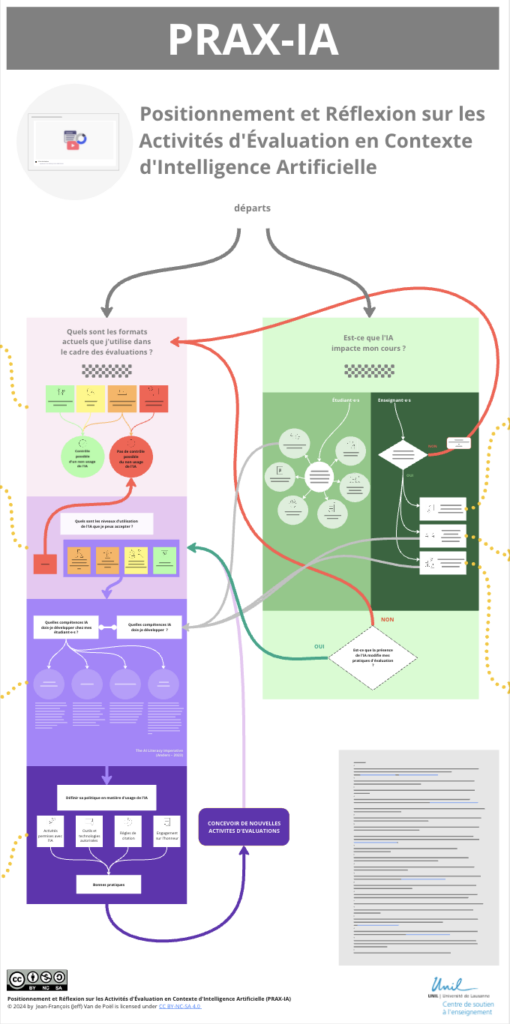

Depuis novembre 2022, l’essor des intelligences artificielles génératives (IAG) a suscité une multitude de réflexions et de débats dans le champ de l’enseignement supérieur. Ces outils, désormais accessibles à un large public, suscitent des questions profondes, notamment en ce qui concerne l’intégrité des évaluations académiques et l’influence des IAG sur les processus d’apprentissage. En réponse à ces transformations, le modèle PRAX-IA a été élaboré comme un cadre de soutien à une réflexion structurée. Il s’appuie sur une revue de littérature en lien avec les pratiques pédagogiques et les applications de l’IA. PRAX-IA vise à soutenir les enseignant·e·s dans leurs interrogations et leurs choix pédagogiques en leur offrant des outils pratiques et un ensemble de ressources à consulter.

Ce modèle s’appuie sur deux axes principaux : une entrée spécifique par le biais des évaluations référencés dans la littérature et une réflexion plus globale sur l’impact de l’IA dans l’ensemble du cours. Chaque axe est enrichi par une base de connaissances documentée et par des ressources pratiques, accessibles via un espace dédié.

Avant de présenter en détail les deux axes du modèle, il est important de souligner que PRAX-IA s’appuie sur une revue de littérature issue d’une veille régulière, visant à rassembler des recherches, des cadres théoriques et des exemples de pratiques liés à l’évaluation, à l’intelligence artificielle et à la pédagogie dans le contexte universitaire. Les ressources proposées dans la section « ressources » du modèle résultent de cette veille hebdomadaire, qui est en constante évolution pour intégrer les contributions les plus récentes et pertinentes.

Première porte d’entrée : les évaluations académiques face aux IAG

L’évaluation est sans doute la dimension la plus impactée par l’émergence des IAG. PRAX-IA propose de commencer par une analyse approfondie des pratiques d’évaluation, avec un triple objectif : identifier les vulnérabilités, définir des stratégies adaptées et élaborer des conditions d’usage cohérentes de l’IA dans les évaluations.

Identifier les types d’épreuves fragilisées

La première étape consiste à inventorier les formats d’évaluation actuellement utilisés (examens, devoirs à domicile, travaux collaboratifs, etc.) pour repérer ceux qui pourraient être particulièrement vulnérables face aux IAG. Cette analyse permet de mieux comprendre quelles épreuves nécessitent des adaptations immédiates. Par exemple, les dissertations à domicile ou les réponses ouvertes pourraient être facilement générées par des IA et doivent donc être repensées.

Définir un niveau acceptable d’usage de l’IA

L’étape suivante consiste à déterminer dans quelle mesure l’usage de l’IA est autorisé ou encouragé dans les évaluations. PRAX-IA introduit à cet effet l’échelle AIAS (Perkins, Furze, Roe, MacVaugh, 2024) un cadre structuré pour évaluer différents niveaux d’intégration de l’IA, depuis son interdiction stricte jusqu’à son incorporation active comme outil d’apprentissage. Ce modèle permet de définir une position claire et cohérente, qui peut ensuite être communiquée aux étudiant·e·s.

La partie « ressources » contient des documents explicatifs sur l’échelle AIAS, ainsi que des exemples d’applications dans différents contextes disciplinaires. Ces ressources permettent également de comparer l’AIAS à d’autres cadres théoriques, offrant ainsi une perspective élargie.

Développer les compétences IA nécessaires

Une fois le niveau acceptable d’usage de l’IA défini, PRAX-IA invite à réfléchir aux compétences IA à développer, tant chez les enseignant·e·s que chez les étudiant·e·s. Le référentiel d’Anders (Anders, 2023), proposé dans le modèle, identifie les savoirs et savoir-faire nécessaires pour intégrer l’IA dans un contexte académique. Ce référentiel peut être utilisé pour définir des objectifs pédagogiques spécifiques, adaptés aux cours et aux disciplines concernées.

Pour faciliter cette démarche, PRAX-IA met à disposition un compagnon IA, un outil interactif qui aide à formuler des Learning Outcomes (objectifs d’apprentissage) en lien avec l’IA. La partie « ressources » offre par ailleurs des référentiels internationaux et des exemples pratiques, illustrant comment ces compétences peuvent être intégrées dans les curriculums existants.

Élaborer des conditions d’usage en lien avec son cours

La réflexion sur les évaluations se termine par une étape stratégique : l’élaboration de conditions d’usage de l’IA, adaptée aux réalités de chaque cours. PRAX-IA propose de structurer ces conditions d’usage autour de quatre axes : la transparence, la régulation, l’intégration pédagogique et l’accompagnement. Là encore, des ressources pratiques et des exemples de bonnes pratiques sont disponibles pour guider les enseignant·e·s et les institutions.

Deuxième porte d’entrée : une réflexion globale sur l’impact de l’IA dans les cours

Si la première porte d’entrée se focalise sur les évaluations, la seconde encourage une réflexion plus large visant à analyser l’impact global de l’intelligence artificielle sur l’ensemble des cours. Cette approche s’appuie sur la notion selon laquelle l’évaluation ne peut être dissociée du contexte pédagogique global : les objectifs d’apprentissage, les activités pédagogiques et les évaluations doivent constituer un ensemble cohérent.

Le canevas de cohérence pédagogique occupe ici une place centrale. Il assiste les enseignant·e·s dans l’analyse de l’alignement entre les divers composants de leur cours, en prenant en considération les modifications potentielles induites par l’intégration de l’intelligence artificielle. Ce cadre leur offre la possibilité de réfléchir de manière structurée aux ajustements requis pour intégrer l’IA de manière pertinente et constructive.

La première question à considérer dans cette démarche est la suivante :

L’intelligence artificielle a-t-elle un impact sur mes cours ?

Cette réflexion implique de saisir de quelle manière les étudiant·e·s utilisent déjà l’IA dans leur processus d’apprentissage. Quels outils utilisent-ils ou utilisent-elles ? Dans quelles circonstances ? Ces pratiques ont-elles une influence sur la manière dont ils interagissent avec le contenu du cours ?

PRAX-IA offre des outils simples destinés à l’observation et à l’analyse de ces usages. Ces outils aident les enseignant·e·s à mieux saisir les implications pédagogiques des technologies employées par leurs étudiant·e·s, dans le but d’identifier les éventuels ajustements à apporter.

Dois-je intégrer l’IA dans mes pratiques enseignantes ?

Si l’intelligence artificielle exerce une influence considérable sur un cours, il devient important de considérer les modalités d’intégration optimale de celle-ci dans le processus d’enseignement. Cette intégration peut prendre différentes formes, selon les disciplines, les besoins des étudiant·e·s, les objectifs pédagogiques et les recommandations institutionnelles.

Dois-je adapter mes objectifs pédagogiques ?

L’intégration de l’intelligence artificielle entraîne fréquemment une réévaluation des objectifs pédagogiques. Ils doivent prendre en considération les compétences spécifiques que les étudiants doivent acquérir en rapport avec l’intelligence artificielle, telles que la capacité à utiliser ces outils de manière critique ou à comprendre leurs limites.

Dois-je adapter mes activités pédagogiques ?

Après la redéfinition des objectifs, il est conseillé d’ajuster ou de concevoir des activités d’apprentissage qui soient en adéquation avec ces nouvelles priorités. Ces activités doivent permettre aux étudiant·e·s de mobiliser l’IA de manière réfléchie et constructive, tout en développant les compétences nécessaires pour en tirer parti.

Boucler la boucle avec l’évaluation

Finalement, cette réflexion globale soulève inévitablement la question de l’évaluation. Si les activités d’apprentissage évoluent pour inclure l’intelligence artificielle, il est impératif d’adapter les pratiques d’évaluation afin de garantir une cohérence pédagogique. Le canevas de cohérence pédagogique sert à structurer cette réflexion, en s’assurant que les ajustements effectués sont en adéquation avec les objectifs et les activités du cours.

Conclusion : Un instrument en développement destiné à soutenir une réflexion collective

PRAX-IA a été créé pour répondre aux défis engendrés par l’apparition des intelligences artificielles génératives (IAG) dans le domaine de l’enseignement supérieur. Ces technologies suscitent des interrogations nouvelles concernant l’évaluation, les apprentissages et la cohérence pédagogique des cours.

Conçu comme un cadre de réflexion, PRAX-IA a pour ambition d’accompagner les enseignant·e·s dans leur adaptation à ce contexte en constante évolution, tout en offrant des outils concrets et des ressources actualisées.

L’objectif principal consiste à favoriser une réflexion critique, que ce soit individuellement ou de manière collégiale sans prétendre offrir des solutions universelles.

PRAX-IA propose deux axes de réflexion : l’adaptation des évaluations et une approche plus globale sur l’impact de l’IA dans les cours, laissant une flexibilité aux enseignant·e·s pour choisir le point de départ qui leur semble le plus pertinent.

Nous vous invitons à le découvrir ! Accéder au modèle

Références

Anders, B. A. (2023). The AI Literacy Imperative: Empowering Instructors & Students. Sovorel Publishing.

Baidoo-Anu, David and Owusu Ansah, Leticia, Education in the Era of Generative Artificial Intelligence (AI): Understanding the Potential Benefits of ChatGPT in Promoting Teaching and Learning (January 25, 2023). Available at SSRN: https://ssrn.com/abstract=4337484 or http://dx.doi.org/10.2139/ssrn.4337484

Burger, B., Kanbach, D.K., Kraus, S., Breier, M., & Corvello, V. (2023). On the use of AI-based tools like ChatGPT to support management research. European Journal of Innovation Management.

Chan, C.K., & Tsi, L.H. (2023). The AI Revolution in Education: Will AI Replace or Assist Teachers in Higher Education? ArXiv, abs/2305.01185.

Cotton, D. R. E., Cotton, P. A., & Shipway, J. R. (2023). Chatting and cheating: Ensuring academic integrity in the era of ChatGPT. Innovations in Education and Teaching International, 61(2), 228–239. https://doi.org/10.1080/14703297.2023.2190148

Fütterer, T., Fischer, C., Alekseeva, A., Chen, X., Tate, T., Warschauer, M., & Gerjets, P. (2023). ChatGPT in education: global reactions to AI innovations. Scientific reports, 13(1), 15310.

Hooda, M., Rana, C., Dahiya, O., Rizwan, A., & Hossain, M. (2022). Artificial Intelligence for Assessment and Feedback to Enhance Student Success in Higher Education. Mathematical Problems in Engineering.

Kilani, A., Hamida, A.B., & Hamam, H. (2019). Artificial Intelligence Review. Advanced Methodologies and Technologies in Artificial Intelligence, Computer Simulation, and Human-Computer Interaction.

Knoth, N., Decker, M., Laupichler, M., Pinski, M., Buchholtz, N., Bata, K., Schultz, B. (2024) Developing a holistic AI literacy assessment matrix – Bridging generic, domain-specific, and ethical competencies, Computers and Education Open, Volume 6, https://doi.org/10.1016/j.caeo.2024.100177.

Mao, J., Chen, B., & Liu, J. C. (2024). Generative Artificial Intelligence in Education and Its Implications for Assessment. TechTrends, 68(1), 58-66.

Montenegro-Rueda, M., Fernández-Cerero, J., Fernández-Batanero, J. M., & López-Meneses, E. (2023). Impact of the implementation of ChatGPT in education: A systematic review. Computers, 12(8), 153.

Moorhouse, B. L., Yeo, M. A., & Wan, Y. (2023). Generative AI tools and assessment: Guidelines of the world’s top-ranking universities. Computers and Education Open, 5, 100151.

Ng, D.T.K., Leung, J.K.L., Su, J. et al. (2023). Teachers’ AI digital competencies and twenty-first century skills in the post-pandemic world. Education Tech Research Dev 71, 137–161 https://doi.org/10.1007/s11423-023-10203-6

Perkins, M. (2023). Academic integrity considerations of AI Large Language Models in the post-pandemic era: ChatGPT and beyond. Journal of University Teaching and Learning Practice.

Perkins, M., Furze, L., Roe, J., MacVaugh, J. (2024). The Artificial Intelligence Assessment Scale (AIAS): A Framework for Ethical Integration of Generative AI in Educational Assessment. Journal of University Teaching and Learning Practice, 21(6).

F. J. Pinzolits, R. (2023). AI in academia: An overview of selected tools and their areas of application. MAP Education and Humanities.

Salas-Pilco, S.Z., Xiao, K., & Hu, X. (2022). Artificial Intelligence and Learning Analytics in Teacher Education: A Systematic Review. Education Sciences.

Salinas-Navarro, D.E.; Vilalta-Perdomo, E.; Michel-Villarreal, R.; Montesinos, L. Using Generative Artificial Intelligence Tools to Explain and Enhance Experiential Learning for Authentic Assessment. Educ. Sci. 2024, 14, 83. https://doi.org/10.3390/educsci14010083

UNESCO. (2024). AI competency framework for teachers. United Nations Educational, Scientific and Cultural Organization. https://doi.org/10.54675/ZJTE2084

UNESCO. (2024). AI competency framework for students. United Nations Educational, Scientific and Cultural Organization. https://doi.org/10.54675/JKJB9835

Xia, Q., Weng, X., Ouyang, F. et al. A scoping review on how generative artificial intelligence transforms assessment in higher education. Int J Educ Technol High Educ 21, 40 (2024). https://doi.org/10.1186/s41239-024-00468-z

Wang, T., Lund, B.D., Marengo, A., Pagano, A., Mannuru, N.R., Teel, Z.(., & Pange, J. (2023). Exploring the Potential Impact of Artificial Intelligence (AI) on International Students in Higher Education: Generative AI, Chatbots, Analytics, and International Student Success. Applied Sciences.

Williams, P. (2023). AI, Analytics and a New Assessment Model for Universities. Education Sciences.